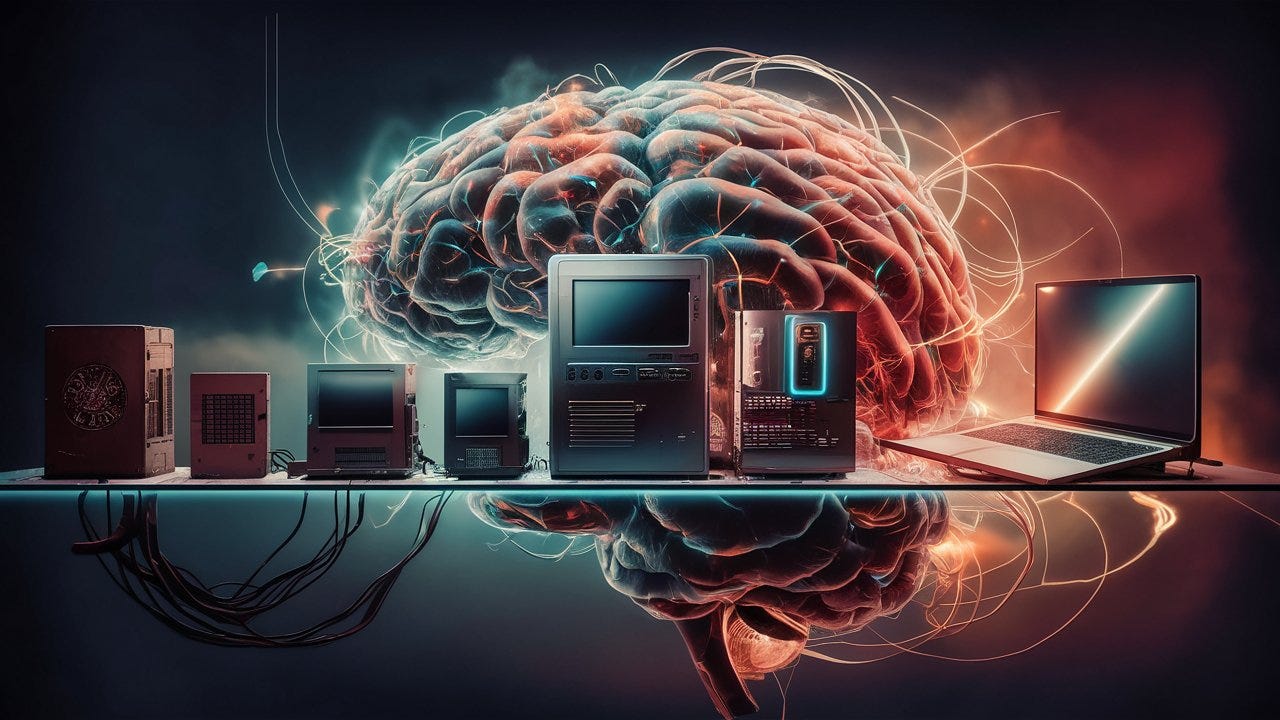

Desde los albores de la computación, cada salto tecnológico ha redefinido las reglas del juego, ampliando lo posible y abriendo caminos antes impensados. La primera gran era comenzó con las máquinas mecánicas, como la máquina diferencial de Charles Babbage, y evolucionó con el cálculo electromecánico de las computadoras de los años 40 del siglo XX. Ahí aparece la máquina, la ENIAC. Con la llegada del transistor en los años 50, se consolidó la computación electrónica, dando paso a la microelectrónica y la Ley de Moore, que permitió la proliferación de los ordenadores personales y la revolución digital.

El paradigma electrónico, basado en la arquitectura de von Neumann, dominó la informática por décadas. Pero sus limitaciones empezaron a ser evidentes. La computación cuántica, con su promesa de superposición y entrelazamiento, plantea una ruptura radical con la computación clásica. Sin embargo, en paralelo a esta revolución cuántica, ha emergido otra visión del futuro computacional: la computación neuromórfica, que se inspira en la estructura y funcionamiento del cerebro para redefinir la manera en que procesamos la información.

Continúa leyendo con una prueba gratuita de 7 días

Suscríbete a 365 relatos de la Inteligencia Artificial para seguir leyendo este post y obtener 7 días de acceso gratis al archivo completo de posts.